Qu’est-ce qu’une hallucination ?

🤖 Hallucination IA : quand les intelligences artificielles perdent les pédales

Imaginez que vous demandez à une IA de vous donner la recette du gâteau au chocolat parfait. Et qu’elle vous répond : « N’oubliez pas d’ajouter une cuillère à soupe de poussière d’étoile. » 🤨 Bienvenue dans le monde fascinant (et parfois absurde) des hallucinations des modèles de langage.

🧠 C’est quoi une hallucination IA ? (Spoiler : non, elle ne voit pas de licornes)

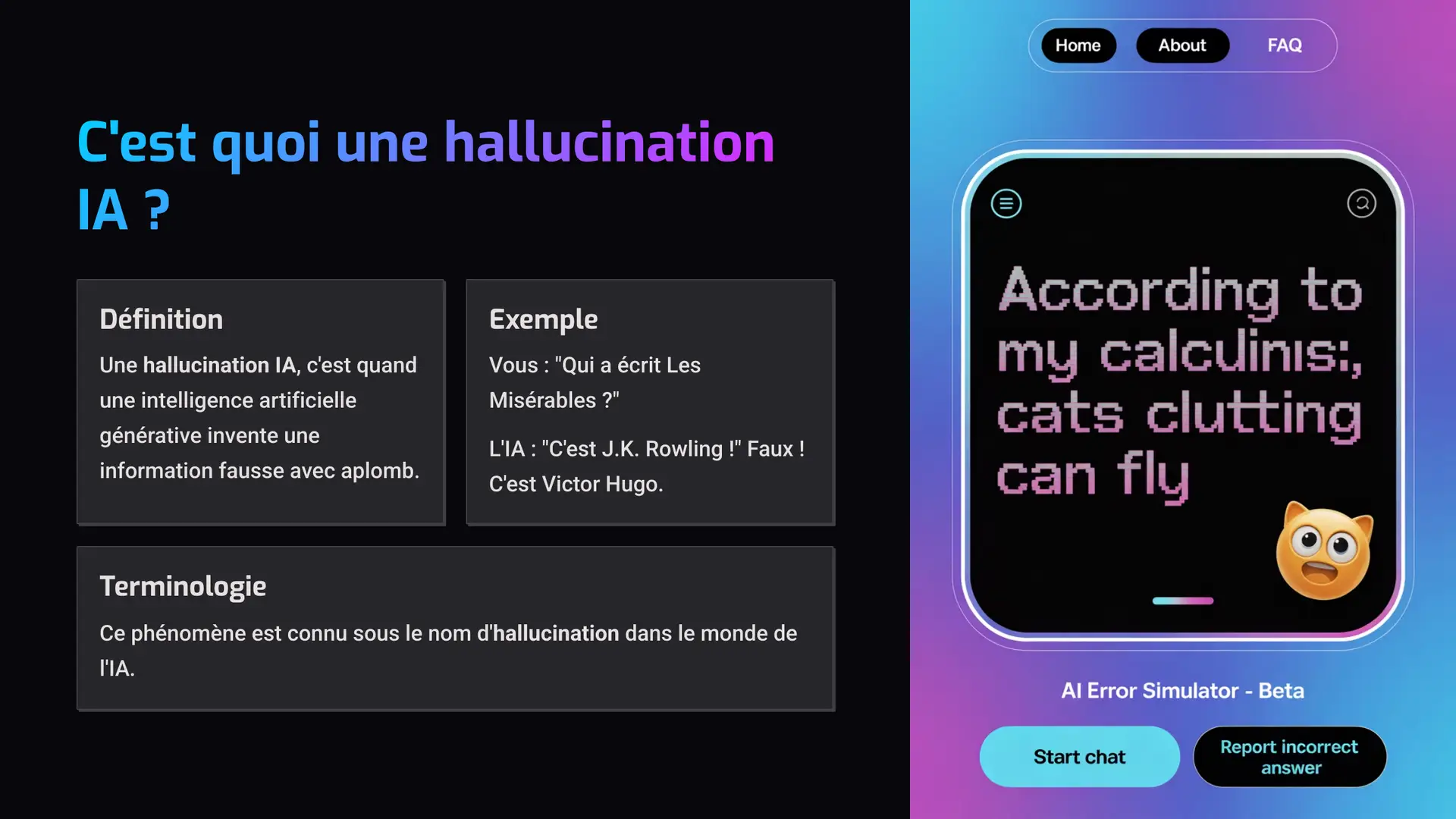

Une hallucination IA, c’est quand une intelligence artificielle générative, comme ChatGPT, invente une information fausse… mais avec un aplomb impressionnant. Elle vous répond un truc qui a l’air crédible, sauf que… c’est complètement faux.

Par exemple :

Vous : “Qui a écrit Les Misérables ?”

L’IA : “C’est J.K. Rowling !”

🛑 Faux ! C’est Victor Hugo, bien sûr. Mais l’IA, elle, a fait une belle erreur de génération de contenu.

Ce phénomène est connu sous le nom d’hallucination dans le monde de l’IA.

🤷♂️ Pourquoi les modèles de langage hallucinent-ils ?

Pour bien comprendre les hallucinations des modèles de langage, il faut savoir comment fonctionne une IA générative. Un LLM (Large Language Model) ne réfléchit pas comme un humain. Il ne comprend pas ce qu’il dit. Il prédit simplement les mots les plus probables en se basant sur d’immenses bases de textes analysées pendant son entraînement.

Donc, quand il manque d’informations ou que la question est floue, l’IA comble les trous avec des réponses imaginaires. Et comme elle est programmée pour être fluide et convaincante, elle le fait avec un style très sûr d’elle.

Un peu comme ce pote qui répond au Trivial Pursuit sans jamais avouer qu’il ne sait pas. 😅

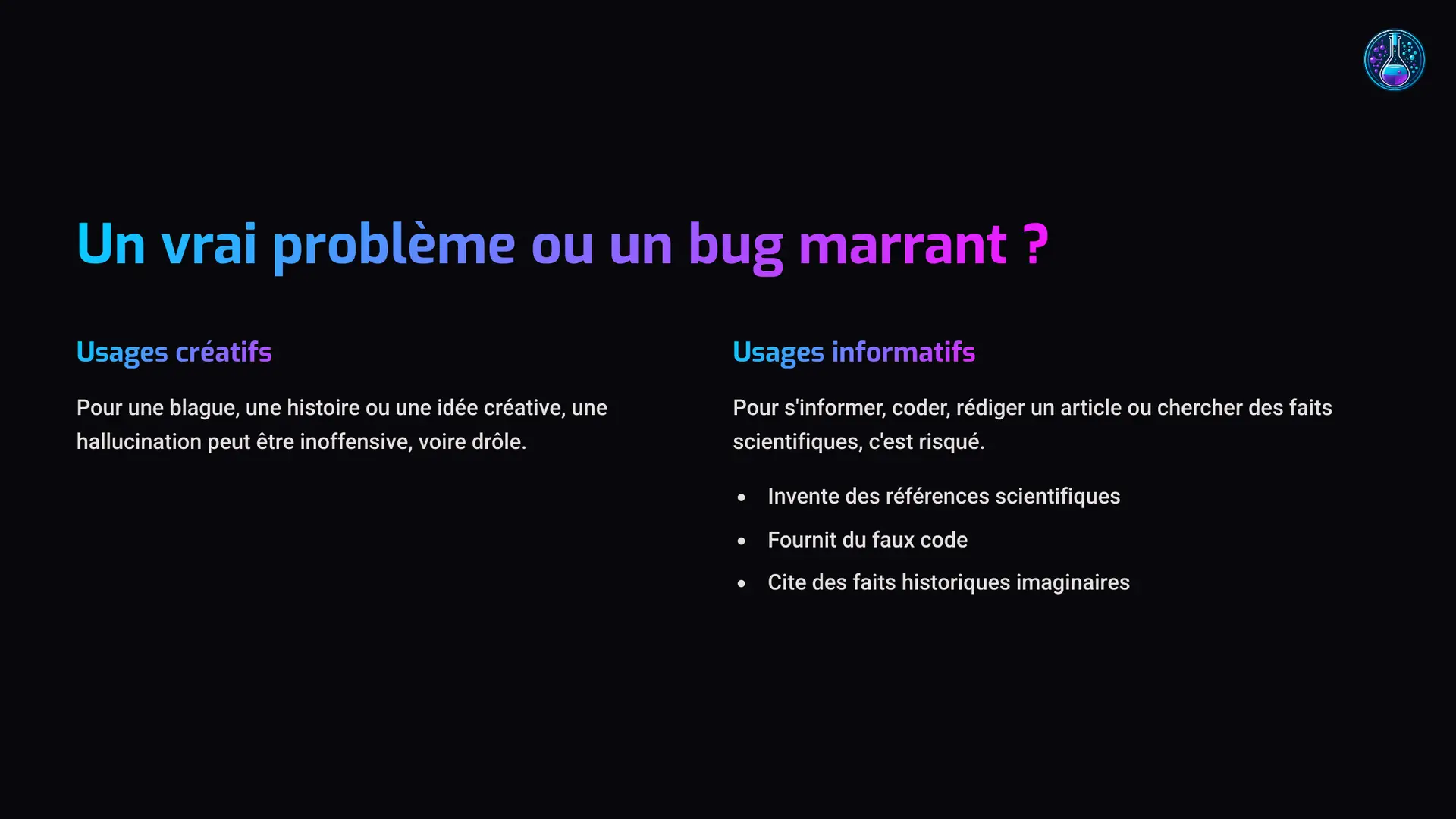

⚠️ Hallucinations IA : un vrai problème ou un bug marrant ?

Cela dépend de l’usage :

Si vous voulez une blague, une histoire ou une idée créative, une hallucination peut être inoffensive (voire drôle).

Mais si vous utilisez une IA pour s’informer, coder, rédiger un article ou chercher des faits scientifiques, c’est là que ça peut devenir risqué.

Car l’IA peut :

Inventer des références scientifiques

Fournir du faux code

Citer des lois ou des faits historiques imaginaires

👉 En bref : les hallucinations des LLM sont un problème de fiabilité.

🛠️ Que font les développeurs pour corriger les hallucinations IA ?

Face à ce défi majeur de l’IA générative, les chercheurs travaillent sur plusieurs fronts pour limiter les hallucinations :

🔍 Entraîner les modèles sur des sources de données plus fiables

🧱 Ajouter des systèmes de vérification des faits (fact-checking intégré)

🌐 Connecter les IA à des bases de données en temps réel (comme Wikipédia ou Bing)

Mais malgré les progrès, aucune solution miracle n’existe encore. Les hallucinations IA restent fréquentes, surtout sur des sujets complexes ou techniques.

🧾 En résumé : faut-il se méfier des hallucinations IA ?

Oui. Et non.

Les hallucinations IA ne sont pas des bugs au sens technique, mais des limites naturelles du fonctionnement des modèles de langage. Ces erreurs sont normales… et prévisibles.

🧠 Gardez donc en tête :

L’IA ne comprend pas ce qu’elle dit.

Elle peut se tromper avec confiance.

Toujours vérifier les informations importantes, surtout dans un contexte pro ou éducatif.

En clair : si une IA vous dit que c’est Napoléon qui a fondé Google, c’est sans doute une hallucination IA, pas une révélation historique.

💡 Des questions, des remarques, ou juste envie de papoter IA ? On ne mord pas (sauf les robots affamés). Rejoins-nous ici